Presentación

En anteriores ocasiones hemos colaborado con Yes We Tech en ofrecer una beca para cubrir los estudios de nuestro Máster Front End, dicha beca estaba orientada a desarrolladoras que ya tenían conocimientos previos de fundamentos de programación.

Esta vez ofrecemos dos Becas que cubren el 100% del coste en nuestro Bootcamp JavaScript: una formación que partiendo de cero, te permite adquirir conocimientos básicos en programación, teniendo como lenguaje de aplicación JavaScript.

¿Cómo funciona este Bootcamp?

- El bootcamp con una serie de módulos que te introduce en el mundo de la programación.

- Cada módulo cuenta:

- Con unas guías para su estudio.

- Con unas sesiones grabadas donde se explican los conceptos básicos (estas son clases que se impartieron

donde también se da respuesta a preguntas de alumnos).

- Con unos laboratorios que la alumna debe entregar para poner en práctica lo aprendido.

- Para ayudarte a lo largo de este camino a la alumna se le asigna un mentor, que está disponible tanto para

dudas cortas como para tutorías (las tutorías se imparten vía videoconferencia).

¿ Qué prerréquisitos tiene?

- Tener conocimientos avanzados de informática a nivel de usuario (manejo del ordenador, herramientas etc...).

- Tener ganas de aprender a programar.

- Tener tiempo disponible.

¿Qué sabré al acabar esta formación?

- Si la programación es algo a lo que te quieres dedicar y se te da bien.

- Dejar de "copiar y pegar" y saber cómo implementar algoritmos.

- Unos conocimientos básicos en desarrollo web.

Es decir, vas a tener una base sólida sobre la que continuar aprendiendo para forjar tu carrera para

desarrolladora Front End.

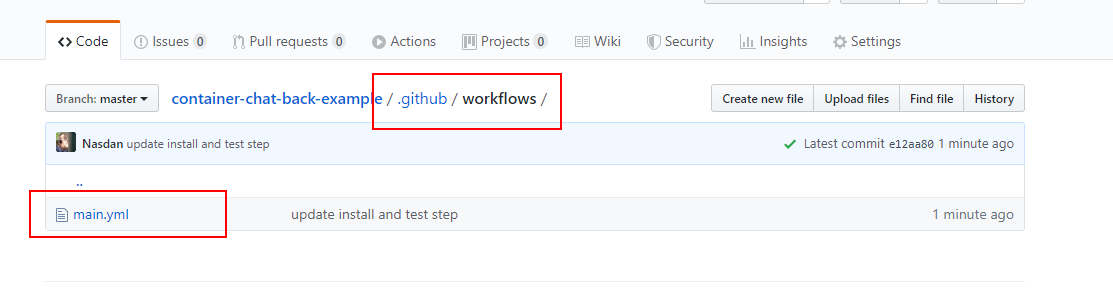

¿Dónde puedo encontrar más información acerca de este Bootcamp?

Su página oficial: https://lemoncode.net/bootcamp-javascript#bootcamp-javascript/inicio

En qué consiste: https://lemoncode.net/lemoncode-blog/2019/10/29/bootcamp-javascript-continuo

Preguntas frecuentes: https://lemoncode.net/lemoncode-blog/2019/11/13/preguntas-frecuentes-bootcamp-javascript-continuo

¿Cuáles son las bases de esta beca?

Hemos trabajado con Yes We Tech y resuelto unas bases para poder inscribiros y seleccionar a la aspirante:

Requisitos

- Pertenecer a minorías con baja representación en el sector profesional, es decir, mujeres y en especial quienes - sean inmigrantes, pertenezcan al colectivo LGTBQIA+, estudiantes y mujeres con diversidad funcional.

- Ingresos inferiores a 27.000€ brutos año o contar con cargas familiares.

- Tener conocimientos de informática a nivel de usuario avanzado.

Criterios de evaluación

- Horas de estudio que la candidata pueda dedicar a la semana.

- Curriculum Vitae.

- Entrevista personal y opción de realizar prueba técnica a las finalistas.

Información mínima a enviar

- Documento personal identificativo (DNI, NIE, Pasaporte)

- Carta explicando los motivos por los que la alumna está interesada en realizar el máster.

- Número de horas de estudio semanal que le puede dedicar al máster

- Curriculum Vitae.

- Información salarial (no es necesario el envío de documentación acreditativa, pero se podría requerir si la candidata llega a finalista).

Fechas

Aceptación candidatas del 2 de noviembre al 31 de diciembre de 2020.

Fecha resolución beca (2 plazas) 11 de Enero de 2020.

Fecha arranque 18 de Enero de 2020

Comite evaluador

Miembros de la comunidad YesWeTech.

Miembros de Lemoncode Formacion S.L.

Para aplicar envíanos un correo con la información que te pedimos a nuestra cuenta de EMail: formacion@lemoncode.net